OpenStack与红帽Ceph集成及CL261考试解析

2025/05/07

作者:博睿谷Eva

以下从技术实践与认证备考两个维度,详细说明红帽Ceph存储(Red Hat Ceph Storage, RHCS)在OpenStack中的部署、优化及CL261(Red Hat Ceph Storage Architecture and Administration)考试核心知识点。

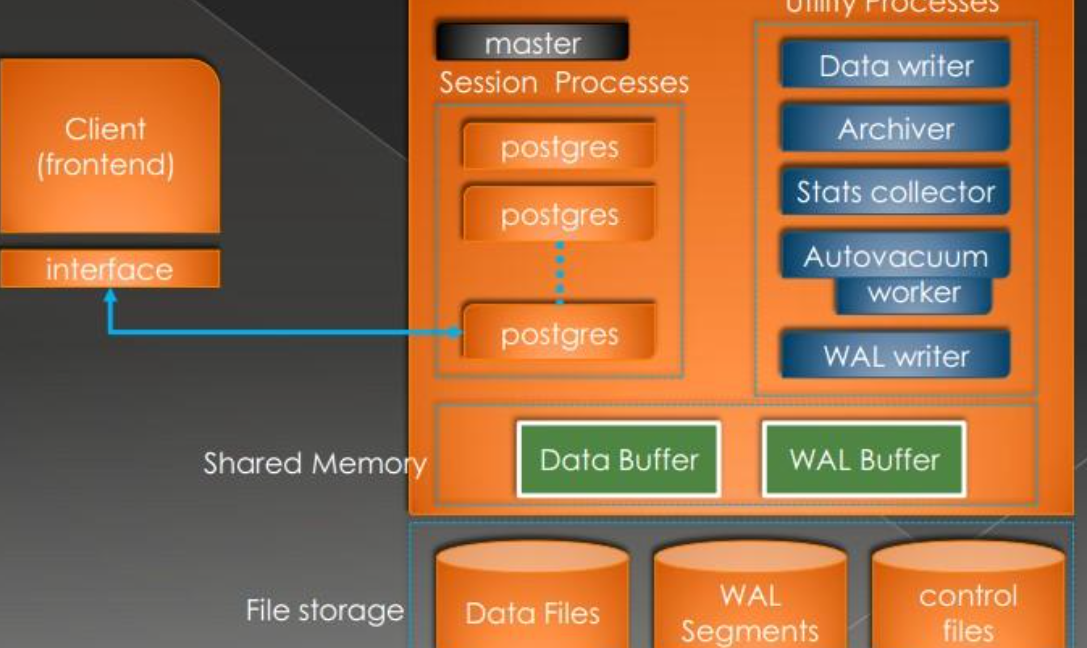

一、Ceph与OpenStack集成架构

1. Ceph在OpenStack中的角色

- 存储服务支持:

- 块存储(Cinder):通过RBD(RADOS Block Device)为虚拟机提供持久化卷。

- 镜像存储(Glance):将虚拟机镜像直接存储于Ceph池中,支持快速克隆。

- 对象存储(Swift替代):通过RGW(RADOS Gateway)兼容S3/Swift API,用于备份或大数据存储。

- 核心优势:

- 统一存储池:避免数据冗余,提升资源利用率。

- 高可用性:数据自动多副本分布(默认3副本),无单点故障。

2. 部署流程(基于RHCS 5.x/6.x)

步骤1:Ceph集群初始化

# 创建Monitor节点 ceph-deploy new node1 node2 node3 # 安装Ceph软件包 ceph-deploy install node1 node2 node3 # 初始化Monitor ceph-deploy mon create-initial # 部署OSD(每个节点至少3块磁盘) ceph-deploy osd create --data /dev/sdb node1 ceph-deploy osd create --data /dev/sdc node1 ...

步骤2:OpenStack服务对接Ceph

Glance配置(/etc/glance/glance-api.conf):

[glance_store] stores = rbd rbd_store_pool = images rbd_store_user = glance rbd_store_ceph_conf = /etc/ceph/ceph.conf

Cinder配置(/etc/cinder/cinder.conf):

[DEFAULT] enabled_backends = ceph [ceph] volume_driver = cinder.volume.drivers.rbd.RBDDriver rbd_pool = volumes rbd_user = cinder rbd_ceph_conf = /etc/ceph/ceph.conf

Nova配置(/etc/nova/nova.conf):

[libvirt] images_type = rbd images_rbd_pool = vms images_rbd_ceph_conf = /etc/ceph/ceph.conf rbd_user = nova

步骤3:权限与密钥配置

# 创建Ceph用户并授权 ceph auth get-or-create client.glance mon 'profile rbd' osd 'profile rbd pool=images' ceph auth get-or-create client.cinder mon 'profile rbd' osd 'profile rbd pool=volumes' ceph auth get-or-create client.nova mon 'profile rbd' osd 'profile rbd pool=vms' # 分发密钥环至OpenStack节点 ceph auth get-or-create client.glance | ssh controller tee /etc/ceph/ceph.client.glance.keyring

二、Ceph存储优化与故障排除

1. 性能调优

CRUSH算法优化:

- 根据硬件拓扑调整CRUSH Map,确保数据均匀分布。

# 定义故障域层级(如rack→host→osd) ceph osd crush add-bucket rack1 rack ceph osd crush move node1 rack=rack1

PG数量调整:

- 每个Pool的PG数建议为 (OSD总数 × 100) / 副本数,例如:

ceph osd pool set images pg_num 128 ceph osd pool set images pgp_num 128

缓存分层(Cache Tiering):

- 创建SSD缓存池加速热点数据访问:

ceph osd tier add volumes volumes-cache ceph osd tier cache-mode volumes-cache writeback ceph osd tier set-overlay volumes volumes-cache

2. 常见故障处理

OSD故障:

# 查看OSD状态 ceph osd tree # 移除故障OSD ceph osd out osd.12 ceph osd crush remove osd.12 ceph auth del osd.12

数据恢复与平衡:

# 强制触发数据重平衡 ceph osd reweight-by-utilization # 限制恢复速度避免影响业务 ceph tell osd.* injectargs '--osd-max-backfills 2'

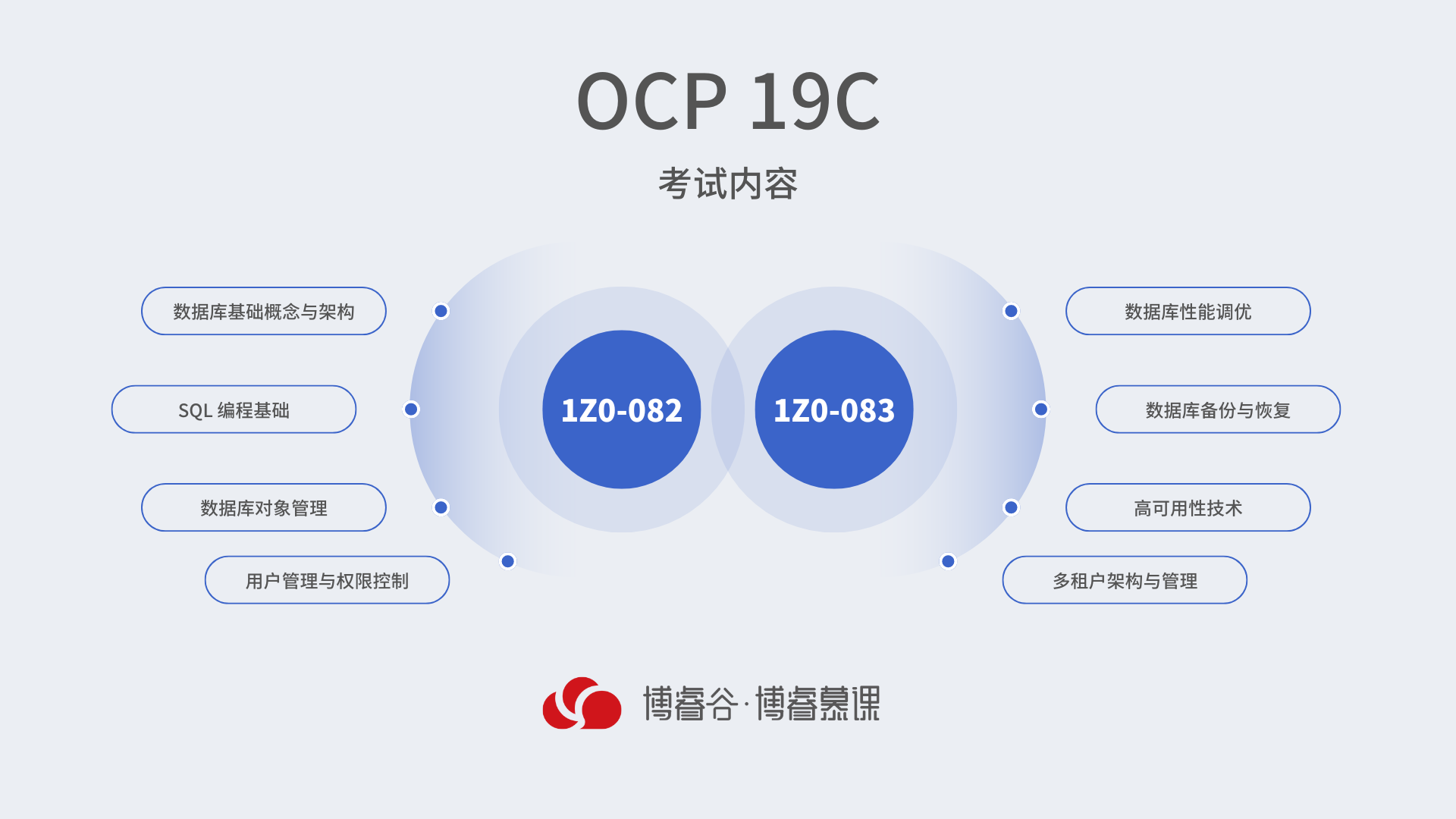

三、CL261考试核心知识点与备考策略

1. 考试大纲重点

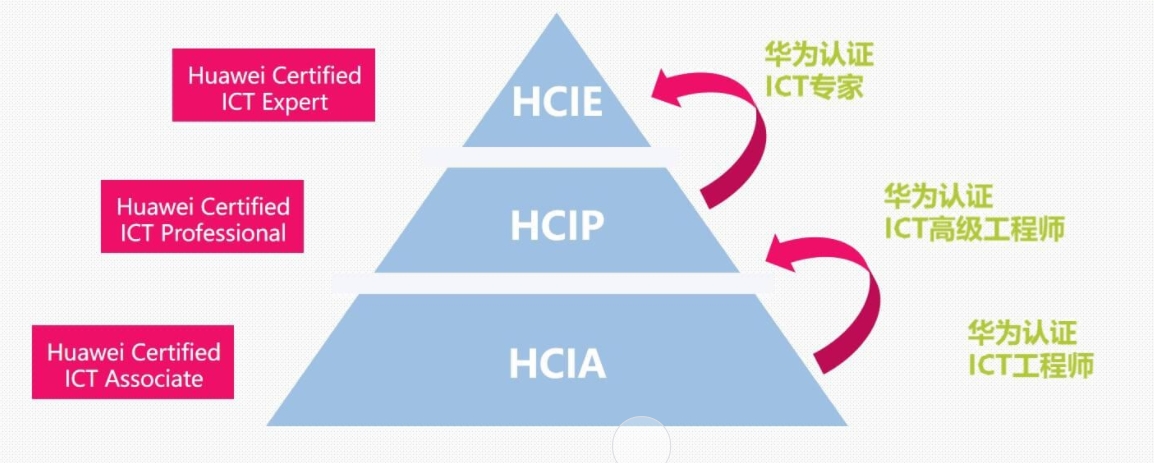

Ceph架构基础:

- RADOS(Reliable Autonomic Distributed Object Store)组件:Monitor、OSD、MDS、RGW。

- 数据分布机制:CRUSH算法、PG(Placement Group)的作用。

存储池管理:

- 创建/删除Pool:ceph osd pool create

- 设置副本策略:ceph osd pool setsize 3

集群监控与维护:

- 使用ceph -s、ceph health detail查看集群状态。

- 日志分析:/var/log/ceph/目录下的mon/osd/mds日志。

安全与权限:

- 用户与能力(Capabilities)管理:ceph auth add、ceph auth caps

2. 实操题型示例

场景1:扩容Ceph集群

# 添加新OSD ceph-deploy osd create --data /dev/sdd node4 # 调整CRUSH Map将新节点加入集群 ceph osd crush add osd.4 1.0 host=node4

场景2:恢复误删除的Pool

- 启用pgp_num与pg_num一致,防止数据丢失。

- 若Pool已删除,需从monitor数据库恢复元数据(需提前开启allow pool delete)。

3. 备考资源推荐

官方文档:

实验环境搭建:

- 使用virt-manager或Vagrant部署多节点Ceph集群(至少3节点)。

- 模拟网络分区、磁盘故障等场景进行恢复训练。

四、最佳实践与考试注意事项

1. OpenStack集成最佳实践

分离存储网络:

- 使用独立万兆网络承载Ceph集群流量(public_network + cluster_network)。

- 配置MTU 9000(Jumbo Frames)降低网络开销。

监控与告警:

- 集成Prometheus + Grafana监控Ceph集群健康状态(如OSD利用率、PG分布)。

- 设置阈值告警(如单个OSD容量>80%触发扩容)。

2. 考试技巧

时间管理:

- 4小时考试中优先完成配置题(占分70%),理论题留至最后。

- 使用ceph -s快速验证操作是否生效。

命令速查:

- 熟记关键命令:ceph osd pool ls、ceph auth list、rados df

- 利用Tab补全和--help参数减少输入错误。

-

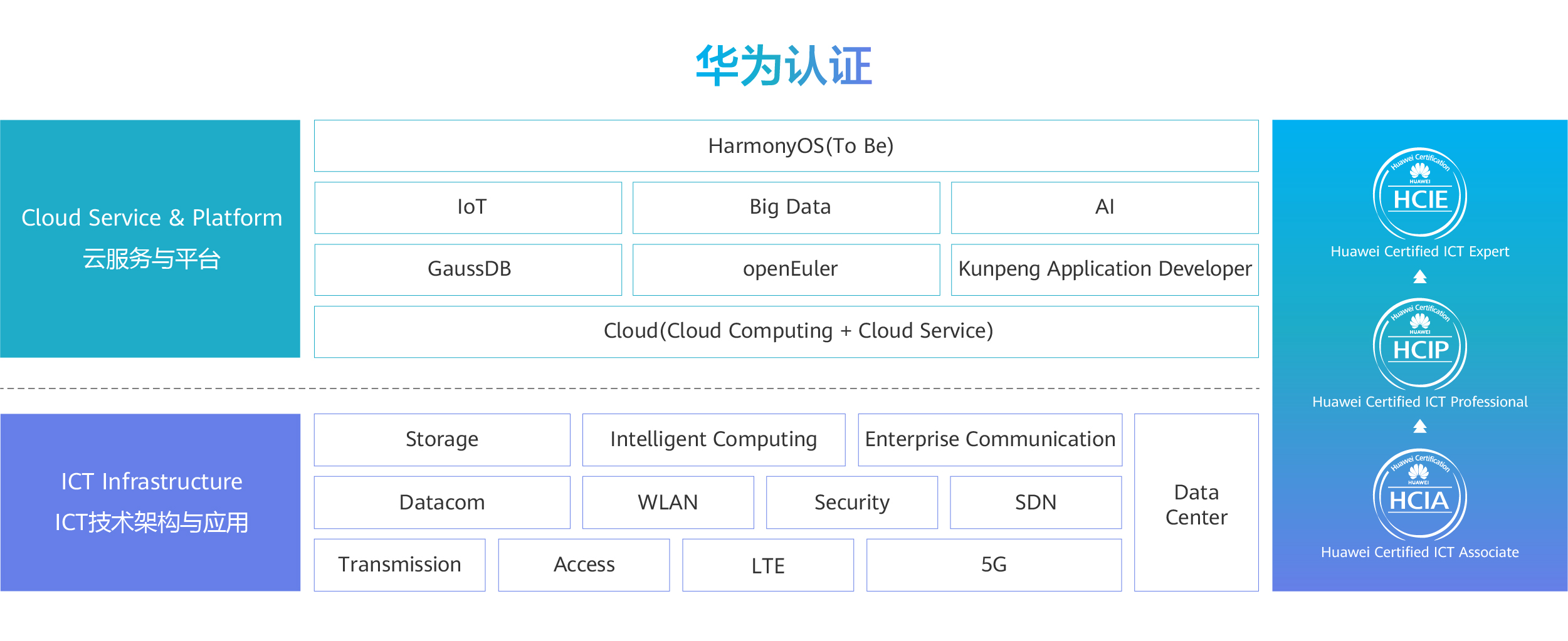

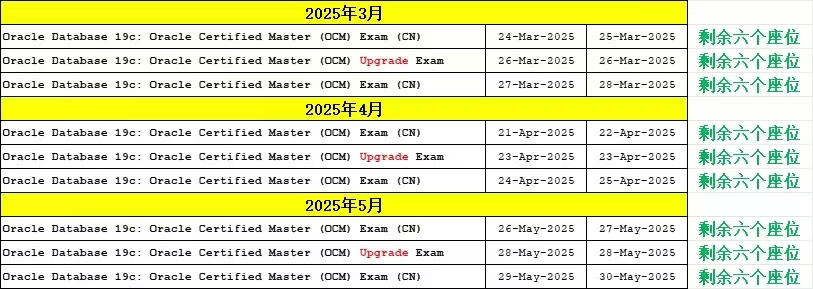

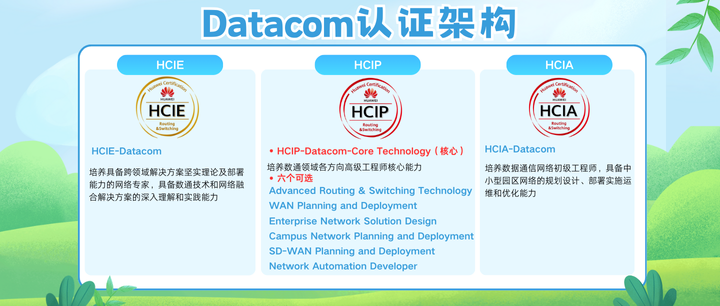

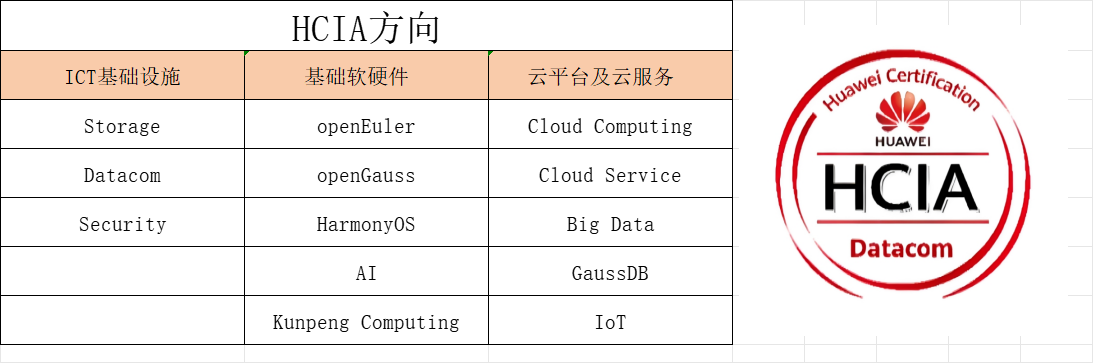

开设课程 开班时间 在线报名OCP2025.04.26

在线报名

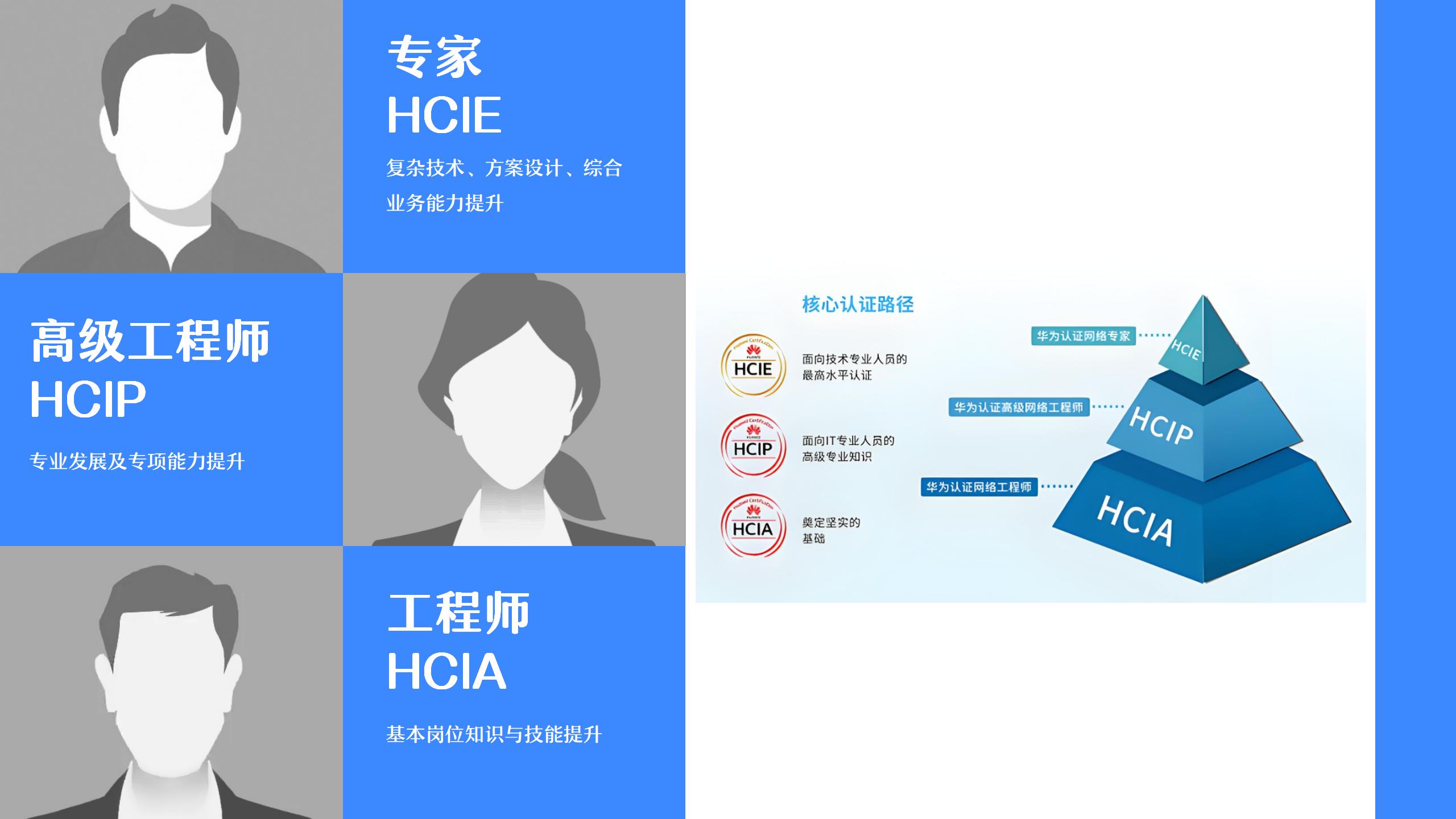

HCIP-AI Solution2025.04.26在线报名

HCIE-openEuler2025.05.03在线报名

RHCA-CL2602025.05.04在线报名

HCIP-Cloud2025.05.10在线报名

PGCM直通车2025.05.10在线报名

HCIA-Datacom(晚班)2025.05.19在线报名

HCIA-Sec2025.06.07在线报名

RHCA-RH4422025.06.07在线报名

PMP2025.06.10在线报名

HCIA-Datacom2025.06.14在线报名

HCIE-AI Solution2025.06.14在线报名

HCIE-Datacom2025.06.14在线报名

HCIP-Datacom(晚班)2025.06.16在线报名

OCM2025.06.21在线报名

HCIE-Cloud2025.06.21在线报名

HCIP-Sec2025.06.21在线报名

HCIE-Bigdata2025.06.28在线报名

RHCE2025.06.28在线报名

HCIE-Datacom考前辅导2025.07.05在线报名

HCIP-Datacom深圳2025.07.19在线报名

CISP2025.07.19在线报名

HCIA-Datacom(晚班)2025.07.21在线报名

RHCA-RH4362025.07.26在线报名

OCP2025.07.26在线报名

HCIE-Sec2025.08.09在线报名

HCIA-AI Solution2025.08.16在线报名

HCIP-Datacom(晚班)2025.08.25在线报名

RHCA-RH3582025.09.06在线报名

PMP2025.09.16在线报名

HCIE-Datacom2025.09.06在线报名

HCIA-AI Solution2025.09.27在线报名

HCIA-Datacom2025.09.27在线报名

PGCM直通车2025.10.11在线报名

RHCA-DO3742025.10.11在线报名

HCIA-Sec2025.10.11在线报名

RHCE2025.10.18在线报名

HCIP-Datacom2025.11.08在线报名

HCIP-Sec2025.11.08在线报名

RHCA-CL2602025.11.15在线报名

OCP2025.11.15在线报名

HCIE-Sec2025.12.13在线报名

HCIE-Datacom2026.01.10在线报名